Misc 88

Web :

Quelles évolutions pour la sécurité ?

1 - Analyse du protocole HTTP/2 : avancée ou régression pour la sécurité ?

2 - HTTPS : peut-on encore faire confiance au cadenas vert ?

3 - Les Web Application Firewall sont-ils vraiment incontournables ?

4 - Présentation des API JavaScript cryptographiques

En savoir plus8,90 € TTC

Anciens Numéros

Exploit Corner

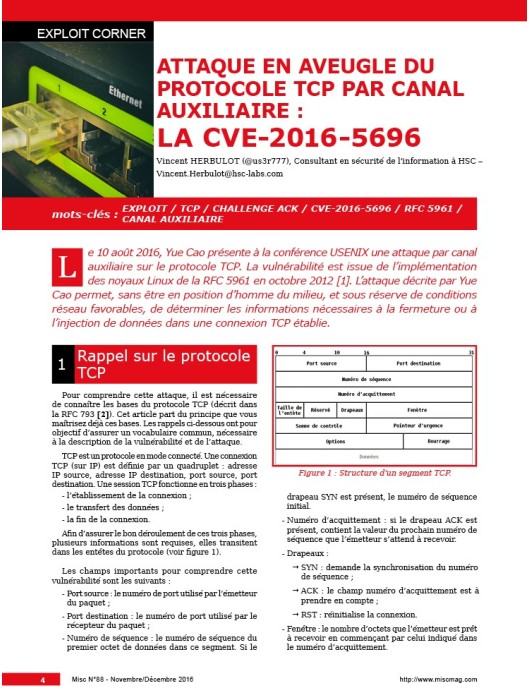

p. 04 Attaque en aveugle du protocole TCP par canal auxiliaire : la CVE-2016-5696

Pentest Corner

p. 12 Bluetooth Low Energy for pentesters

Malware Corner

p. 20 #Analyse d'un fichier Flash délivré par l'Exploit Kit Neutrino

Dossier

p. 24 Préambule

p. 25 HTTP/2 : attention, peinture fraîche !

p. 34 HTTPS : bientôt le fond de l’abîme ?

p. 40 Web Application Firewall 101

p. 49 De la sécurité vers la confidentialité des données

Organisation & Juridique

p. 54 La sécurité des objets connectés

Code

p. 60 DevOps : nuageux, avec chance de sécurité

Système

p. 66 La sécurité dans les systèmes de transports intelligents

Cryptographie

p. 74 Attaques par canaux auxiliaires utilisant les propriétés du cache CPU

Le mot de passe, ce grand cadavre à la renverse

La publication de la base de comptes utilisateurs de Yahoo le 22 septembre dernier avec son demi-milliard d’identifiants est largement la plus grosse fuite de données rendue publique à ce jour et a de quoi donner le vertige. C’est peut-être le dernier clou dans le cercueil de cette société, ce géant du Web déchu qui pouvait se payer en 2000 des publicités en prime time à la télévision à une époque où elle était encore regardée par tous [1].

Mais au-delà de cette énième fuite d’information, ce qui, rétrospectivement, pourrait étonner un informaticien de la fin des années 1990 est que nous continuons, en 2016, à utiliser des mots de passe, voire dans le cas des banques des codes PIN, pour accéder à nos données les plus sensibles.

Le rapport que nous entretenons avec nos mots de passe est compliqué. Tout le monde est convaincu que ce système est mort depuis 30 ans, mais ce système est plus présent que jamais. En tant que responsables SSI, nous nous sommes souvent vu donner des recommandations lors de campagnes de sensibilisation à la sécurité que nous ne suivions bien souvent pas *nous-mêmes. Les plus anciens se souviennent certainement qu’il était, au début des années 2000, usuel de filer la métaphore de la brosse à dents. Outre le choix d’un mot de passe très compliqué et différent pour chaque compte, il fallait, comme une brosse à dents, le changer fréquemment et ne pas le prêter. Les plus intégristes forçaient techniquement un changement mensuel en vérifiant que chaque nouveau mot de passe était différent des six derniers. Enfin tout ce qu’il fallait faire pour que les mots de passe soient écrits sur des post-its dans tous les bureaux. Cette pratique peut paraître surannée à l’heure où il semble généralement admis qu’il vaille mieux un bon mot de passe que des mauvais (ou des bons, mais écrits sur des post-its, partage réseau, cloud public...) changés souvent. C’est pourtant encore la pratique dans certaines structures ou sur les portails de certaines banques qui obligent toutes les 100 connexions un renouvellement du code PIN de 6 chiffres.

En résumé, nous expliquions doctement à nos utilisateurs qu’il fallait un mot de passe robuste, ne jamais utiliser le même pour deux sites et les changer très souvent. Exactement le genre de conseils que personne ne suit, à commencer par celui qui les donne.

Certaines solutions ont eu leurs heures de gloire dans les entreprises et administrations telles que les PKI ou les terminaux OTP [2]. Si séduisantes techniquement et sûres qu’elles puissent être, ces solutions au regard de leur complexité et du coût de leur mise en œuvre, notamment en matière d’assistance aux utilisateurs, ont découragé beaucoup de DSI et n’ont réussi à être implémentées que dans les plus grandes (ou les plus riches) structures. L’administration fiscale qui avait réussi le tour de force de mettre en place une PKI avec des certificats utilisateurs d’authentification sur tous les postes des utilisateurs a fait machine arrière au bout de quelques années pour en revenir à ce bon vieux mot de passe. La complexité de ce type de solution pour les utilisateurs et le coût induit en matière d’assistance n’a certainement pas joué en faveur de la PKI.

Pourtant, avec la massification de l’usage des smartphones, des mécanismes d’authentification renforcés basés sur des SMS ou des applications ad hoc sont possibles même si elles tardent à se généraliser. De plus en plus de services délèguent l’aspect épineux de l’authentification (et de la base de login/mot de passe à préserver) à des fournisseurs d’identité tels que Google, Microsoft, Facebook ou Twitter. On peut déjà noter des efforts très louables pour rendre l’authentification à deux facteurs possible de la part de Google, Twitter, Dropbox, GitHub, Microsoft ou encore Blizzard. Il ne reste qu’à espérer que les utilisateurs adoptent ce mécanisme massivement, ou soient poussés à le faire par des mesures incitatives, et que cette bonne pratique soit adoptée par tous les fournisseurs d’identité.

Cedric Foll / cedric@miscmag.com / @follc

[1] http://www.ina.fr/video/PUB2327350047 [2] Je me souviens avec nostalgie des formations à l’utilisation de clefs OTP où mes stagiaires notaient le numéro affiché sur l’écran LCD pour ne pas avoir à ressortir leur clef.

La publication technique des experts de la sécurité offensive & défensive

Face à la transformation digitale de notre société et l’augmentation des cybermenaces, la cybersécurité doit être aujourd’hui une priorité pour bon nombre d’organisations. Après plus de 20 années de publications et de retours d’expérience, MISC apporte un vivier d’informations techniques incontournable pour mieux appréhender ce domaine. Précurseur sur ce terrain, MISC a été fondé dès 2002 et s’est peu à peu imposé dans la presse française comme la publication de référence technique en matière de sécurité informatique. Tous les deux mois, ses articles rédigés par des experts du milieu vous permettront de mieux cerner la complexité des systèmes d’information et les problèmes de sécurité qui l’accompagne.

Soyons clairs, je ne suis pas fan de Lua en tant que langage de programmation. Le simple fait que les tableaux débutent à l'indice 1 me perturbe totalement et constitue pour moi une véritable aberration. Mais, d'un autre côté, Lua est aussi le langage par excellence lorsqu'il s'agit d'embarquer des fonctionnalités de scripting au sein d'une application ou d'un outil. Du moins, c'est ce que tend à montrer sa popularité dans ce domaine et, si l'on n’a jamais tenté l'expérience, on peut se demander pourquoi. La réponse est évidente après quelques lignes de code et on se surprend soi-même à dire, à haute voix qui plus est, « Ah ! Mais c'est excellent, en fait ! ».

Si vous croyez que le format ASCIIZ (aussi appelé « chaîne de caractères à terminateur nul » à la base du langage C et d’UNIX) est le pire péché originel de l’informatique, accrochez-vous. Il est amplifié par un autre péché bien plus grave, commis au nom du minimalisme, excusé au nom de la compatibilité et perpétué par l’oubli des alternatives. Si vous avez lu l’article de mars 2023 [1] jusqu’au bout, vous avez probablement compris que la plupart des langages de programmation actuels n’utilisent qu’une seule pile. C’est la source de nombreux problèmes (de sûreté, de sécurité, de complexité et bien d’autres) aux origines de failles variées (représentant peut-être un cinquième des CVE) que nous sommes habitués à mitiger, sans les résoudre vraiment. Dans cette première partie lovecraftienne, nous irons jusqu’au fond de l’impasse pour démontrer l’absurdité, les difficultés et les dangers imposés par ce système.

Au détour d'un petit projet incluant des échanges USB avec un adaptateur série utilisant une puce FTDI FT232R, j'ai rencontré un problème susceptible de survenir dans diverses situations. Même si aujourd'hui UTF-8 semble avoir toujours été présent dans nos terminaux, éditeurs, codes et que sais-je encore, les utilisateurs et programmeurs les plus aguerris se souviennent sans peine de la souffrance vécue lors de la transition depuis le bon vieux Latin1 (alias iso-8859-1). Mais la dure réalité est la suivante : UTF-8 n'est pas partout !