GNU/Linux Magazine 181

7,90 € TTC

Anciens Numéros

Actualités

p. 06 Kunai, le service discovery simplement

Humeur

p. 14 Notre 11 septembre : mêmes effets et mêmes conséquences

Repères

p. 18 Le premier ordinateur à circuit intégré est allé sur la Lune

Algo / IA

p. 26 La compression dans tous ses états

Sysadmin / Netadmin

p. 36 Des bits comme s'il en pleuvait : une appliance SAN/NAS sous NetBSD

Python

p.48 Authomatic : Python, OAuth et réseaux sociaux

Android

p. 54 Cordova : quoi de neuf ?

Code

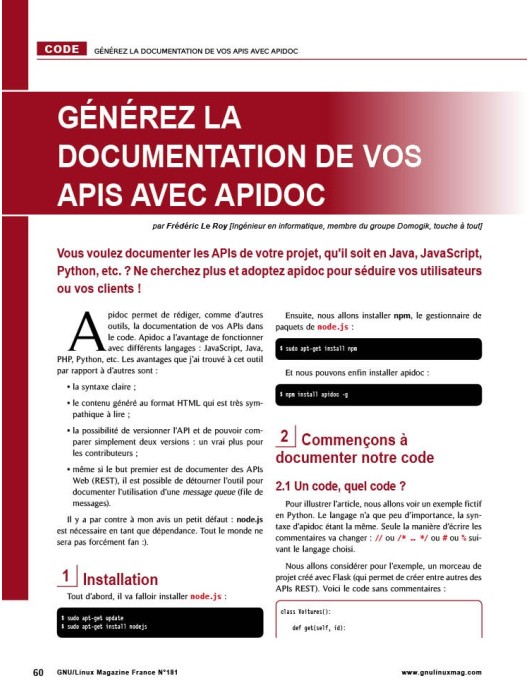

p. 60 Introduction à PostScript – Éléments du langage

p. 66 Générez la documentation de vos APIs avec apidoc

p. 76 Planificateur – les outils

De jour en jour la quantité de données que nous collectons augmente. Ces données il faut les stocker, ce qui occupe forcément un espace physique non négligeable. Plus la quantité de données croît, plus il faut d'espace pour les stocker, c'est logique. Mais que se passe-t-il si l'espace de stockage ne croît pas suffisamment vite ? Il me vient à l'esprit une image couramment employée pour montrer l'expansion de l'Univers et qui peut s'appliquer ici. La question de départ est la suivante : pourquoi ne fait-il pas jour tout le temps puisque les étoiles emplissent l'Univers de lumière ? Ceci s'explique par l'expansion de

l'Univers : si nous prenons un robinet qui coule à débit constant pour remplir une baignoire, mais que cette baignoire grossit sans cesse, l'eau ne pourra jamais la remplir et déborder. L'eau représente la lumière et la baignoire l'Univers : l'Univers étant en expansion, la lumière émise ne pourra jamais le remplir. Dans le cas des données, on peut se dire que l'on se retrouve dans la même situation : la quantité de données acquise croît, mais dans le même temps les capacités

de stockage croissent encore plus vite... (sinon Google aurait de gros problèmes avec Gmail). Mais à force de stocker tout et n'importe quoi, de ne plus faire le ménage dans nos données et d'en collecter toujours plus de manière automatisée, ne va-t-il pasarriver un moment où notre capacité de stockage nous fera défaut ?Nos smartphones ont des capteurs de plus en plus performants et,sans modification des paramètres comme le font la plupart des gens,

il faut être en possession d'un volume de mémoire assez conséquent pour conserver des « photos ». Heureusement que ces dernières utilisent

un format compressé, un format qui nécessite un

traitement avant de pouvoir être archivé,

de manière à occuper le moins

de place possible.

Une fois

compressées, il faut

passer par une étape de

décompression, les données n'étant pas

lisibles en l'état. Ce mois-ci vous pourrez expérimenter

différents algorithmes de compression pour en disséquer lefonctionnement et adapter éventuellement l'un d'entre eux aux

données que vous manipulez et ne plus dépendre exclusivementde l'expansion de l'espace de stockage.J'espère que vous aurez noté que, pour la première fois, cet édito aura revêtu la forme d'un calligramme ! Un poisson aurait sans doute été de mise en ce mois d'avril, mais un poisson compressé n'aurait pas été du meilleur effet en première page...

Tristan Colombo

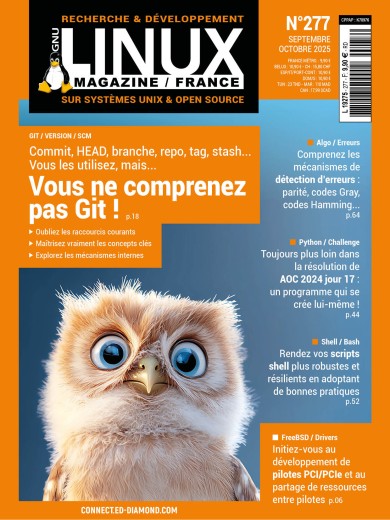

Le magazine de référence technique pour les développeurs sur systèmes open source et les ingénieurs R&D !

GNU/Linux Magazine s'adresse aux professionnels et aux particuliers désireux de mieux maîtriser les techniques et problématiques liées à la programmation et à l’utilisation de solutions open source. Tous les deux mois avec ses articles techniques, la publication couvre les thématiques suivantes : programmation système, algo, bas niveau, sécurité du code, développement web...

La domotique, c'est fantastique ! Surtout quand ça ne coûte pas trop cher, que ça rend service aussi bien pour le contrôle des lumières, le suivi de la consommation électrique, le contrôle de l'environnement ou l'automatisation, et que tout cela fonctionne avec du logiciel libre, sans exfiltrer des tonnes de données privées chez un fournisseur qui se fera tôt ou tard pirater. Mais à trop vouloir jouer la carte de la sécurité, on se prive parfois de certains avantages. Trouvons donc le bon compromis pour rendre notre installation accessible, sans créer d'énormes brèches...

Nombre de phénomènes physiques qui nous entourent peuvent être décrits par un graphe d'états. Ce dernier représente les états successifs du phénomène en question, par exemple, les différents états de l'eau : état solide, état liquide et état gazeux. Il en est de même pour la majorité des systèmes que nous utilisons couramment : machine à café, lave-linge, automobile, distributeur de boissons, jusqu'à aller au comportement même des threads gérés par votre système d'exploitation.

Durant mes pérégrinations dans le petit monde du développement FPGA avec LiteX s'est posée une problématique intéressante, consistant à devoir écrire un support pour une interface série (UART) en n’ayant à disposition rien d'autre qu'une poignée de registres où lire ou écrire. Cet exercice, pour moi, était une phase préalable à l'implémentation d'un pilote pour un système d'exploitation, mais serait transposable à n'importe quel type d'interface reposant sur des mécanismes similaires, et ce, sur n'importe quel MCU ou SoC, actuel ou ancien. Faisons donc connaissance avec l'UART LiteX, voulez-vous ?