Gnu/Linux Magazine 199

Moteur de recherche :

Créez un robot qui fouille le web pour vous !

- Développez un web crawler

- Implémentez un moteur d'indexation

7,90 € TTC

Anciens Numéros

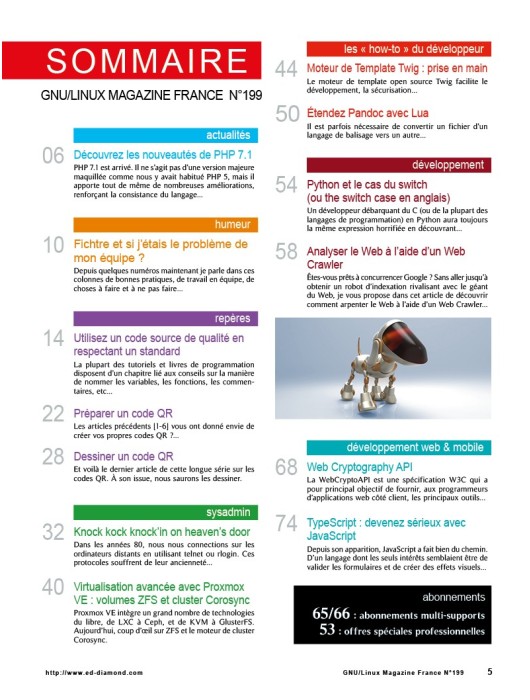

Actualités

p. 06 Découvrez les nouveautés de PHP 7.1

Humeur

p. 18 Fichtre et si j’étais le problème de mon équipe ?

Repères

p. 14 Utilisez un code source de qualité en respectant un standard

p. 22 Préparer un code QR

p. 28 Dessiner un code QR

Sysadmin

p. 32 Knock kock knock’in on heaven’s door

p. 40 Virtualisation avancée avec Proxmox VE : volumes ZFS et cluster Corosync

Les « how-to » du développeur

p. 44 Moteur de Template Twig : prise en main

p. 50 Étendez Pandoc avec Lua

Développement

p. 54 Python et le cas du switch (ou the switch case en anglais)

p. 58 Analyser le Web à l’aide d’un Web Crawler

Développement web & mobile

p. 68 Web Cryptography API

p. 74 TypeScript : devenez sérieux avec JavaScript

À quoi sert le Web si l'on ne peut pas le parcourir et trouver les informations que l'on souhaite ?

Aujourd'hui, il suffit d'ouvrir un moteur de recherche (bien souvent Google) et de taper sa requête pour obtenir une réponse pertinente en quelques secondes... pour peu que l'on sache construire la requête correctement. Le fait d'obtenir cette information paraît naturel mais, pour les plus vieux d'entre nous (ou les moins jeunes devrais-je dire), rappelez-vous qu'il y a quelques dizaines d'années nous utilisions des annuaires (Yahoo ! étant le premier d'entre eux). Excite introduisit ensuite les bases des véritables moteurs de recherche. Ces moteurs prirent alors l'aspect de portails et se livrèrent une guerre sans merci. Les sociétés qui proposaient ces moteurs perdirent peu à peu de vue le fait que les utilisateurs souhaitaient se focaliser sur la recherche et elles multiplièrent les sources de distraction (puisque nous sommes sur un portail) de manière à engranger un maximum de revenus publicitaires. De plus, la recherche n'était pas particulièrement efficace... et c'est alors qu'apparût Google, qui écrasa tous les autres.

De nos jours peu de moteurs résistent encore à l'hégémonie de Google. On peut citer par exemple DuckDuckGo, Qwant ou encore Bing. Chacun fera alors son choix en estimant la pertinence des réponses. Notons également la présence de méta-moteurs : des sites qui interrogent différents moteurs de recherche et qui agrègent les réponses. Certains de ces méta-moteurs sont un peu particuliers : ils n'interrogent qu'un seul moteur, mais permettent d'assurer la confidentialité de vos recherches (comme Startpage).

Derrière tous les moteurs de recherche se trouve la même mécanique : parcourir le Web, collecter des informations et les indexer en fonction de critères propres à chaque moteur. Dans ce numéro, nous vous proposons de revenir sur les bases des moteurs de recherche, de créer votre Web Crawler pour l'envoyer fouiller les pages web à la recherche des informations qui vous intéressent. Vous pourrez en quelque sorte créer vos propres espions du Web numériques : lancez vos robots le soir et récupérez vos données au petit matin. Parcourez les pages à la recherche d'erreurs, de liens morts, étudiez l'évolution des sites dans le temps... devenez le maître du Web (à ponctuer par un rire guttural :-)).

Pour finir, comme vous l'aurez sans doute remarqué, le numéro 200 approche à grands pas (ainsi que la nouvelle année, comme cela avait été calculé au lancement du magazine... si, si :-)). Nous avons décidé de nous servir de ce numéro un peu spécial pour marquer le coup en vous proposant une nouvelle formule qui se veut un peu plus proche de l'esprit des débuts. De nouvelles rubriques verront le jour. Lesquelles ? Comment ? Vous le saurez le mois prochain...

Tristan Colombo

Le magazine de référence technique pour les développeurs sur systèmes open source et les ingénieurs R&D !

GNU/Linux Magazine s'adresse aux professionnels et aux particuliers désireux de mieux maîtriser les techniques et problématiques liées à la programmation et à l’utilisation de solutions open source. Tous les deux mois avec ses articles techniques, la publication couvre les thématiques suivantes : programmation système, algo, bas niveau, sécurité du code, développement web...