GNU/Linux Magazine HS 78

Analyse de données & Big Data

Le guide pour manipuler et analyser vos données efficacement !

En savoir plus12,90 € TTC

Anciens Numéros

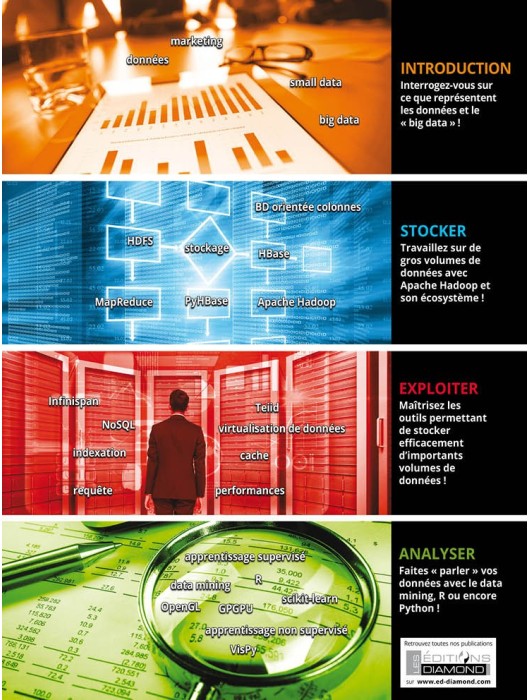

Introduction

p. 08 Stockage et exploitation : des données aux « big data »

Stocker

p. 14 Hadoop

p. 26 HBase

Exploiter

p. 42 Indexez vos données sans limites à l'aide de Infinispan

p. 58 Teiid, unifiez vos données et simplifiez votre architecture

Analyser

p. 86 Introduction au data mining en Python avec scikit-learn

p. 94 Analyse statistique de données avec R

p. 116 Visualisation interactive de données avec VisPy

Pour le meilleur et pour le pire, nous vivons dans un monde de données. Que cela soit bénéfique ou néfaste, suivant l’origine des données ou leur utilisation, nous n’y pouvons rien changer, c’est un fait : nous produisons de plus en plus de données.

Comme ce fait ne peut être modifié, nous devons nous adapter, adapter nos comportements et nos outils pour pouvoir stocker et traiter une telle masse d’informations.

Ces outils vont se répartir en deux catégories :

- les outils de stockage qui permettront de conserver les données et d’y accéder de manière efficace au vu de leur taille ;

- les outils d’analyse sans lesquels les données ne nous seront d’aucune utilité.

Nous avons élaboré ce hors-série de manière à ce que vous puissiez être efficace dans chacune de ces étapes. Les outils présentés ne représentent bien sûr qu’une infime partie des logiciels et systèmes disponibles, mais ils sont représentatifs de ce que l’on peut faire dans le domaine et devraient vous aider à cibler vos besoins et vous donner des pistes pour des solutions répondant à vos propres problématiques.

Bien sûr, nous parlons de « big data », puisque le terme est à la mode, mais ne croyez pas que nous soyons dupes, l’aspect marketing sous-jacent ne nous a pas échappé et vous vous en rendrez compte au fil de la lecture du magazine. Ce qui nous intéresse et ce sur quoi ce magazine se focalisera, ce sont les données, les adaptations nécessaires pour pouvoir traiter de gros volumes d’informations et les analyser. Les perspectives offertes par la possibilité de collecter ces données et de les analyser sont énormes et permettent d’accélérer notre vitesse d’acquisition de nouvelles connaissances ou plus simplement de les valider. Mais il faut prendre garde à un écueil qui nous guette dans cette frénésie de données : la qualité des données récoltées ! Il est possible, sciemment, de manipuler les nombres, de les orienter dans une direction particulière à dessein. C’est du détournement d’information, mais la démarche est consciente. Des données erronées peuvent amener à des conclusions tout autant fausses, mais sans en avoir forcément conscience.

Avec l’augmentation drastique des données, il faut donc non seulement posséder une infrastructure informatique capable de soutenir leur « poids », mais en plus être extrêmement vigilant en terme d’analyses. En somme il y a du travail, mais ce magazine devrait vous aider...

La Rédaction

Le magazine de référence technique pour les développeurs sur systèmes open source et les ingénieurs R&D !

GNU/Linux Magazine s'adresse aux professionnels et aux particuliers désireux de mieux maîtriser les techniques et problématiques liées à la programmation et à l’utilisation de solutions open source. Tous les deux mois avec ses articles techniques, la publication couvre les thématiques suivantes : programmation système, algo, bas niveau, sécurité du code, développement web...

La domotique, c'est fantastique ! Surtout quand ça ne coûte pas trop cher, que ça rend service aussi bien pour le contrôle des lumières, le suivi de la consommation électrique, le contrôle de l'environnement ou l'automatisation, et que tout cela fonctionne avec du logiciel libre, sans exfiltrer des tonnes de données privées chez un fournisseur qui se fera tôt ou tard pirater. Mais à trop vouloir jouer la carte de la sécurité, on se prive parfois de certains avantages. Trouvons donc le bon compromis pour rendre notre installation accessible, sans créer d'énormes brèches...

Que faut-il pour reproduire un badge NFC (Near Field Communication) ? Bien qu’il n’y paraisse rien, un badge NFC est en réalité une véritable prouesse d’électronique et d’informatique embarquée. Comment un simple « bout de plastique », sans aucun composant électronique visible ni alimentation, peut-il communiquer et échanger des informations avec un autre système informatique, sans même un contact physique, par le simple fait de sa proximité avec un lecteur ? Dans cet article, nous expliquerons en détail le fonctionnement d’un badge NFC et chercherons à créer un badge « maison ». Après avoir conçu une antenne adaptée, nous analyserons le protocole de communication entre le lecteur et le badge, puis tenterons de reproduire le comportement du badge pour leurrer le lecteur NFC. Tout cela nous amènera à réviser la physique des ondes électromagnétiques et à revoir plusieurs montages électroniques courants. Nous découvrirons également le périphérique RMT (Remote Controller) de l’ESP32, qui permet de générer des signaux temporels rapides et stables, tout en gérant de manière indépendante les interruptions du processeur pour synchroniser l’envoi des réponses.

Dans le précédent article [1], nous avons affiné notre configuration pour supporter pleinement toute la richesse de ce que le langage C et la chaîne de compilation peuvent offrir en termes d'adressage mémoire, et sommes même allés jusqu'à utiliser ces mécanismes pour piloter une série de 64 LED adressables WS2812. Mais tout ceci se passe depuis « l'intérieur » du SoC lui-même et il est temps à présent d'accéder à cet espace depuis le monde extérieur.